Si nous nous intéressons à la qualité des données des organisations, c’est naturellement parce qu’elle est souhaitable, à la fois au service des enjeux de Customer Experience et d’Intelligence Artificielle précédemment mentionnés. Mais aussi de façon générale pour améliorer la prise de décision, opérationnelle ou stratégique. En disposant de données de meilleure qualité (entre autres : à jour, exhaustives, exactes), une organisation pourra par exemple adapter sa stratégie de manière plus certaine aux évolutions du marché. Mais aussi déceler et cibler plus facilement les problèmes le long de ses processus opérationnels, ou encore réduire la probabilité de certains risques (risques réglementaires, risques de production ou d’approvisionnement…).

La question suivante se pose alors naturellement : comment « atteindre » la qualité de données ? Ou du moins, si l’on considère la question sous un angle moins binaire, comment améliorer la qualité de ses données ?

Si nous partons de zéro, une première étape serait évidemment de mesurer la Data Quality. Après tout, on n’améliore pas ce qu’on ne mesure pas. Nous avions précédemment proposé une définition de la Data Quality, en évoquant notamment ses différentes dimensions (validité, exactitude, exhaustivité, unicité entre autres). Commençons par nous doter d’indicateurs précis portant sur chaque dimension. Une vision consolidée de ces indicateurs (ou une moyenne pondérée) nous donnera alors le baromètre de notre Data Quality.

Par exemple, sur la dimension de validité, l’indicateur en question pourra être le suivant : sur 100 valeurs d’un champ dans une table donnée, combien sont conformes à la spécification de format attendue pour ce champ ?

Mais ici nous rencontrons un premier obstacle. De quelle spécification de format parle-t-on ? D’ailleurs en existe-t-il pour tous les champs sur toutes les tables ? Si oui, ces spécifications sont-elles en cohérence les unes avec les autres ? Qu’est-ce qui nous assure que pour de nouveaux champs ajoutés à une table (nouvelle ou existante), des spécifications pertinentes vont être établies ? Et en admettant que ces spécifications existent et soient cohérentes entre elles, quelle est la prochaine étape si je veux augmenter la valeur de mon indicateur. Auprès de qui aller déceler les points de dysfonctionnement et les pistes d’améliorations ?

Nous sommes vite submergés de questions via cette première méthode. Il nous manque un cadre. Ce cadre, il nous est possible de le modéliser par un système de processus.

Dans toute démarche qualité ou d’excellence opérationnelle (ISO-9001, Lean, Six Sigma, …), la définition des processus occupe une place centrale. Il faut d’abord savoir de quoi on parle et comment fonctionnent les choses avant de tenter de les améliorer. De même, une démarche d’amélioration de la Data Quality va d’abord passer par la définition des processus qui impactent la qualité de données au sein d’une organisation. L’ensemble de ces processus forme une composante essentielle de ce que nous nommerons la Gestion de la Qualité de Données, ou Data Quality Management (abrégé « DQM » ci-après), et que la norme ISO-8000 définit comme « l’ensemble coordonné des activités visant à orienter et piloter une organisation au regard de la qualité de ses données. »

De même que lors de notre exploration du concept de Data Quality, la norme ISO-8000 va encore une fois nous servir ici de boussole. La section ISO-8000-61 propose en effet un modèle de processus de DQM. Si ces processus ont tous une raison d’être, l’importance relative de chacun d’eux au service de l’objectif d’amélioration de la Data Quality reste bien entendu à apprécier en fonction des spécificités de chaque organisation (notamment de sa taille, sa couverture géographique et son caractère centralisé / décentralisé).

Et la gouvernance des données dans tout ça ? La norme ISO-8000 situe le DQM au sein d’une notion plus large de gouvernance de données, qu’elle définit comme « le développement et la mise en application de politiques relatives à la gestion des données ». Une définition plus large et plus abstraite nous est donnée par le DMBOK (Data Management Book Of Knowledge) : « L’exercice de l’autorité, du contrôle et de la prise de décision partagée (planification, pilotage et mise en application) sur la gestion des actifs de données ». La distinction majeure est que la gouvernance des données peut inclure d’autres axes relatifs à la donnée, non systématiquement liés à sa qualité. Par exemple, sa confidentialité, sa sécurité, ou encore l’acculturation d’une organisation à la donnée(1). Pour nos besoins, retenons que la gouvernance de données englobe la DQM, qui est l’une de ses dimensions, focalisée sur les processus, les rôles et responsabilités relatifs à la Data Quality. Nous nous concentrerons ci-après sur la notion de DQM uniquement.

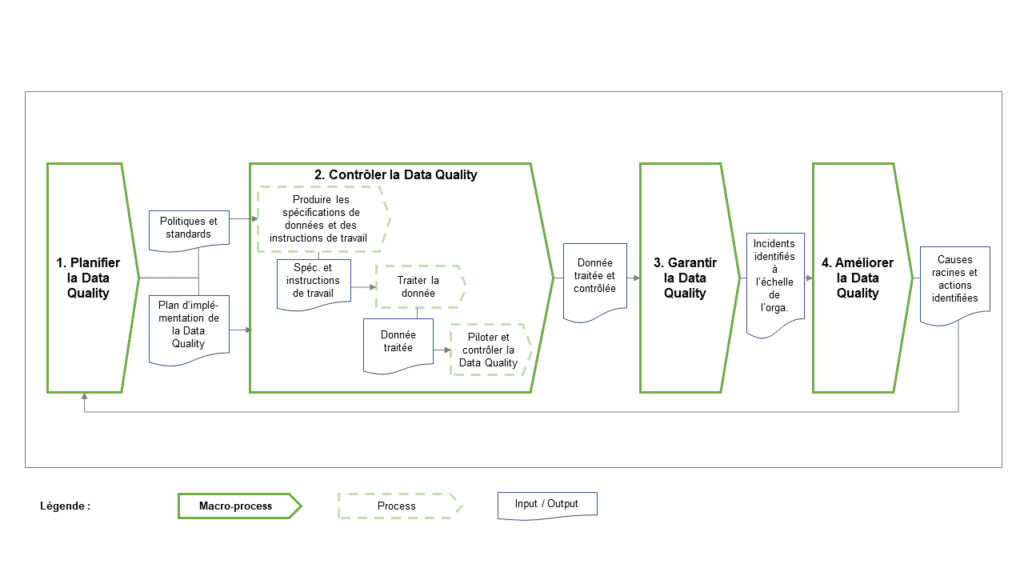

Le modèle de processus de Data Quality Management (DQM) proposé par la norme ISO-8000-61

Comme souvent lorsqu’il s’agit de qualité, les 20 processus de DQM proposés par la norme ISO-8000-61 s’organisent sous forme d’une roue de Deming ou cycle « Plan-Do-Check-Act », avec quelques à-côtés ou processus supports. Les 14 processus principaux (c’est-à-dire hors support) sont donc regroupés en 4 macro-processus :

- Planifier la Data Quality (4 pr.) : préparer les conditions de contrôle de la Data Quality à l’échelle de l’organisation, en définissant notamment les grandes lignes directrices (standards et politiques, plan de travail…)

- Contrôler la Data Quality (3 pr.) : traiter les données à l’échelle unitaire, en ayant défini au préalable les conditions particulières auxquelles doivent obéir ces données (spécifications) et ceux qui les traitent (instructions de travail)

- Garantir la Data Quality (4 pr.) : se doter des conditions d’évaluation de la Data Quality à l’échelle de l’organisation, et détecter les dysfonctionnements systémiques

- Améliorer la Data Quality (3 pr.) : travailler sur ces dysfonctionnements jusqu’à identifier et résoudre leurs causes racines

L’articulation de ces macro-processus entre eux peut se résumer dans le schéma suivant :

Pour les évoquer le contenu de ces macro-processus en détail, il est plus aisé de commencer par le deuxième macro-processus « Contrôler la Data Quality », qui lui-même s’articule autour d’un premier processus central : « Traiter la donnée. » C’est le cœur du réacteur, qui regroupe les tâches des faiseurs de la donnée : « créer, utiliser, mettre à jour et supprimer les données » (ISO-8000-61). Les autres processus peuvent se comprendre comme des boucles de qualité concentriques qui viennent entourer ce traitement de la donnée, à commencer par « Produire les spécifications de données et des instructions de travail. » En effet, le premier réflexe pour garantir la qualité du traitement d’une donnée particulière est de lui apporter un cadre « législatif » de proximité, qui définit d’abord les exigences que la donnée doit satisfaire (spécifications : quel format attendu, quelle ancienneté maximum, quel niveau de détail…), puis la façon de la traiter pour que ces exigences soit satisfaites (instructions de travail : quelle fréquence de mise à jour, quelle fréquence d’archivage…) Puis, il s’agit ensuite de mettre en place un cadre « judiciaire » de proximité : « Piloter et contrôler la Data Quality. » Ici, toujours par rapport au traitement d’une donnée particulière, on s’intéresse notamment à la façon dont la bonne application des spécifications va être contrôlée. Il est bien entendu possible, et même souhaitable, d’automatiser ce processus de confrontation de la donnée aux spécifications qui lui sont associées.

Une fois passé ce macro-processus central, qui relève aussi bien du traitement de la donnée que de son contrôle, il est pertinent de prendre un peu de hauteur en revenant au premier macro-processus de notre liste « Planifier la Data Quality. » Prendre de la hauteur, car nous ne nous situons plus ici à l’échelle d’une donnée particulière (ex : tel champ issu de telle table), mais à l’échelle de l’organisation tout entière, toutes données confondues. Il est alors question de savoir si les objectifs quant à la Data Quality sont partagés à travers l’organisation, si les règles de gestion de la donnée sont harmonisées, ou encore, dans le cas où elles ne le sont pas, comment prioriser la gestion de la Data Quality. L’un des processus majeurs de ce domaine de planification est la gestion des politiques, standards et procédures de Data Quality. Les standards établissent des règles communes pour la création des spécifications de données, et les politiques sont leur équivalent concernant les instructions de travail. Il s’agit encore une fois d’une boucle de qualité concentrique que l’on vient appliquer aux processus précédents. Sans s’attarder sur tous les processus que comprend ce macro-processus dans le modèle ISO-8000, notons qu’il s’agit ici aussi bien de planifier le DQM à long terme (à travers un plan stratégique en accord avec la stratégie de l’entreprise) que de façon opérationnelle (à travers un plan d’implémentation incluant jalons, ressources humaines et financières nécessaires au développement du DQM).

L’étape et le macro-processus suivants consistent à Garantir la Data Quality. Par là, on entend se doter, encore une fois à l’échelle de l’organisation et non plus de la donnée particulière, de critères de mesure globale de la Data Quality, qui nous permettent de constater la progression d’ensemble, les éventuels problèmes rencontrés, et les éventuels écarts qu’ils engendrent par rapport aux objectifs. L’ensemble des processus évoqués précédemment peuvent en effet être dysfonctionnels, que ce soit dans la planification ou le contrôle de la Data Quality. Il s’agit ici notamment d’identifier ces dysfonctionnements et de prioriser leur traitement. On parle alors d’approche systémique(2) de la qualité des données. Le dernier macro-processus Améliorer la Data Quality est une continuation directe du précédent, où l’identification des problèmes se poursuit dans la recherche des causes racines, dont vont découler des mesures correctives et préventives (notamment : nettoyage des données, modifications des processus précédents).

Il n’est pas envisageable, ni même souhaitable, que tous ces processus soient mis en place du jour au lendemain au sein d’une organisation. C’est pourquoi il est utile d’adopter une approche par niveaux de maturité successifs qui garantissent la bonne adoption du modèle d’ensemble. C’est notamment ce que propose l’ouvrage Managing Data Quality A practical guide by King, Tim, Schwarzenbach, Julian, en s’inspirant des niveaux de maturité bien connus du CMMI (Capability Maturity Model Integration).

(1) Cf. Data governance and data quality: Is it on your agenda?, A. Young & K. McConkey, 2012

Ne vous demandez plus si vos données sont de qualité !

Découvrez notre solution de Data Quality

augmentée par la Data Science et le Machine Learning.

Les rôles et responsabilités associées aux processus de DQM

À la lumière des processus mentionnés ci-dessus, il peut être intéressant de s’interroger sur les rôles et responsabilités associés à chacune des actions dont ces processus se composent. Nous en dirons ici un mot rapide, car les termes consacrés sont nombreux et peuvent varier d’une organisation à une autre.

Il existe de façon récurrente deux rôles fréquemment associés à la notion de Gestion de la Qualité des Données :

- À un échelon de direction, celui de Chief Data Officer ou CDO, qui selon les organisations peut siéger au comité exécutif, et qui a pour fonction de faciliter les activités de spécification, acquisition, exploitation et stockage de la donnée pour l’ensemble des projets et collaborateurs(3). Dans notre contexte, il sera responsable d’impulser et de suivre la mise en place du DQM.

- À un échelon d’exécution, celui de Data Steward, le « faiseur » de la donnée, généralement rattaché au CDO, responsable de la gestion d’un ensemble de données spécifiques. On distingue parfois le Business Data Steward, en interface avec le métier, qui peut notamment être en charge de la rédaction des spécifications, standards et politiques ; de son pendant technique le System Data Steward, qui va effectivement être capable de localiser les données dans les différents systèmes et savoir comment agir dessus.(4)

Si le CDO est généralement un rôle à plein temps, celui de Data Steward peut selon la maturité des organisations être porté à temps partiel par un acteur déjà en poste, sans nécessité de modification majeure des organigrammes.

(2) Managing Data Quality: A practical guide by King, Tim, Schwarzenbach, Julian

(3) Managing Data Quality: A practical guide by King, Tim, Schwarzenbach, Julian

(4) The Chief Data Officer Handbook for Data Governance, Sunil Soares

Conclusion

Si nous reprenons notre question initiale : « Comment une organisation peut-elle améliorer la qualité de ses données ? », nous pouvons désormais apporter une réponse. En mettant en place un système de Gestion de la Qualité des Données. Bien sûr, il s’agit d’une réponse à tiroirs, et de nombreux sous-projets et actions vont découler de ce chantier.

Néanmoins, nous avons vu ensemble une façon logique de dérouler ce chantier. En commençant à l’échelle de la donnée particulière par la définition de spécifications et de règles de gestion, pour venir ensuite harmoniser ces règles de gestion à l’échelle de l’organisation et planifier leur mise en œuvre. Et enfin, aboutir à une vision systémique de la qualité de données où les principaux dysfonctionnements à l’échelle de l’organisation sont analysés à fréquence régulière et donnent lieu à des plans d’actions correctives et préventives. Le bon déroulement de ces étapes sera facilité par la présence d’un Chief Data Officer, accompagné de Data Stewards aux profils plus opérationnels.

Comme nous l’avons rappelé, ces étapes ne sont qu’une trajectoire possible, basée sur la proposition d’ISO-8000. Il est par exemple tout à fait envisageable, au sein du processus de contrôle de la qualité des données, de ne pas systématiquement confronter les données à des spécifications, mais d’utiliser des méthodes d’évaluation de la Data Quality et de détection d’erreurs embarquant davantage d’intelligence. C’est d’ailleurs ce que nous proposons à travers notre solution novencia Data Quality IA, notamment lorsque les organisations sont confrontées à une grande variété de données et de règles de gestion, et qu’elles ont besoin de prendre du recul par rapport à la pertinence de ces dernières. Dans tous les cas, la mise en place d’une Gestion de la Qualité des Données nécessitera forcément l’acculturation de vos collaborateurs à la donnée – sujet que nous vous proposons de découvrir dans un prochain article.